La inteligencia artificial puede adivinar con exactitud si la gente es gay o heterosexual basada en fotos de sus rostros, de acuerdo con una nueva investigación que sugiere que las máquinas pueden tener significativamente mejores «gaydar» que los humanos.

El estudio de la Universidad de Stanford, que encontró que un algoritmo de computadora podría distinguir correctamente entre hombres homosexuales y heterosexuales el 81% de la veces, y el 74% para las mujeres, ha planteado preguntas sobre los orígenes biológicos de la orientación sexual, la ética de la tecnología de detección facial , y el potencial de este tipo de software para violar la privacidad de las personas o abusar de las mismas con fines anti-LGBT.

La inteligencia de la máquina probada en la investigación, que fue publicada en la Journal of Personality and Social Psychology y se informó por primera vez en The Economist, se basó en una muestra de más de 35.000 imágenes faciales que hombres y mujeres publicaron en un sitio web de citas estadounidense. Los investigadores, Michal Kosinski y Yilun Wang, extrajeron características de las imágenes usando «redes neurales profundas», lo que significa un sofisticado sistema matemático que aprende a analizar visuales basadas en un gran conjunto de datos.

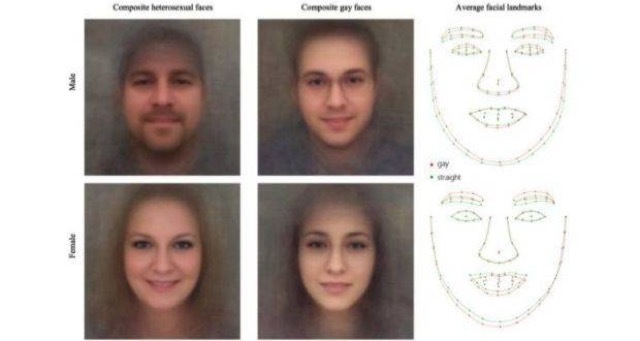

La investigación encontró que los hombres y las mujeres gays tendían a tener características, expresiones y «estilos de aseo» atípicos de género, esencialmente significando que los hombres gais parecían más femeninos y viceversa. Los datos también identificaron ciertas tendencias, incluyendo que los hombres homosexuales tenían mandíbulas más estrechas, narices más largas y frente más grande que hombres heterosexuales, y que las mujeres gais tenían mandíbulas más grandes y frente más pequeña en comparación con las mujeres heterosexuales.

Los jueces humanos desempeñaron mucho peor que el algoritmo, identificando con precisión la orientación sólo el 61% del tiempo para los hombres y el 54% para las mujeres. Cuando el software revisó cinco imágenes por persona, tuvo todavía más éxito, el 91% del tiempo con los hombres y el 83% con las mujeres. En términos generales, eso significa que «las caras contienen mucha más información sobre la orientación sexual de la que puede ser percibida e interpretada por el cerebro humano«, escribieron los autores.

El documento sugiere que los hallazgos proporcionan un «fuerte apoyo» a la teoría de que la orientación sexual proviene de la exposición a ciertas hormonas antes del nacimiento, es decir, que las personas nacen homosexuales y queer no es una opción. La menor tasa de éxito de la máquina para las mujeres también podría apoyar la idea de que la orientación sexual femenina es más fluida.

Si bien los hallazgos tienen claros límites cuando se trata de género y sexualidad, las personas de color no fueron incluidas en el estudio, y no se consideraron las personas transexuales o bisexuales, las implicaciones para la inteligencia artificial son amplias y alarmantes. Con miles de millones de imágenes faciales de personas almacenadas en sitios de redes sociales y en bases de datos gubernamentales, los investigadores sugirieron que los datos públicos podrían ser utilizados para detectar la orientación sexual de las personas sin su consentimiento.

Es fácil imaginar a los cónyuges que usan la tecnología en sus parejas de las que sospechan que están en el armario, o adolescentes que usan el algoritmo en sí mismos o en sus compañeros. Más horroroso puede ser en los gobiernos que continúan procesando a personas LGBT podrían usar hipotéticamente la tecnología para salir y dirigir a las poblaciones. Eso significa que la construcción de este tipo de software y su divulgación es en sí misma polémica dada la preocupación de que podría fomentar las aplicaciones dañinas.

Sin embargo, los autores argumentaron que la tecnología ya existe y que sus capacidades son importantes para exponer de manera que los gobiernos y las empresas puedan considerar proactivamente los riesgos de privacidad y la necesidad de salvaguardias y regulaciones.

«Es ciertamente inquietante. Al igual que cualquier otra herramienta, si se pone en manos equivocadas, puede utilizarse para malos propósitos «, dijo Nick Rule, profesor asociado de psicología de la Universidad de Toronto, que ha publicado una investigación sobre la ciencia del gaydar. Si usted puede comenzar a perfilar a la gente en función de su apariencia, a continuación, identificarlos y hacerles cosas horribles, eso es realmente malo.

Rule sostuvo que todavía era importante desarrollar y probar esta tecnología: «Lo que los autores han hecho aquí es hacer una declaración muy atrevida sobre lo poderoso que esto puede ser. Ahora sabemos que necesitamos protecciones «.

Kosinski no estaba inmediatamente disponible para hacer comentarios, pero después de la publicación de este artículo el viernes, habló sobre la ética del estudio y las implicaciones para los derechos LGBT. El profesor es conocido por su trabajo en la Universidad de Cambridge en el perfil psicométrico, incluyendo el uso de datos de Facebook para sacar conclusiones sobre la personalidad. La campaña de Donald Trump y los partidarios de Brexit desplegaron herramientas similares para apuntar a los votantes, planteando preocupaciones sobre el uso creciente de datos personales en las elecciones.

En el estudio de Stanford, los autores también señalaron que la inteligencia artificial podría ser utilizada para explorar vínculos entre rasgos faciales y una gama de otros fenómenos, tales como opiniones políticas, condiciones psicológicas o personalidad.

Este tipo de investigación también plantea preocupaciones sobre el potencial de escenarios como la película de ciencia ficción Minority Report, en la cual las personas pueden ser arrestadas basándose únicamente en la predicción de que cometerán un crimen.

«La inteligencia artificial puede decirle cualquier cosa sobre cualquier persona con suficientes datos«, dijo Brian Brackeen, CEO de Kairos, una compañía de reconocimiento facial. «La pregunta es como sociedad, ¿queremos saber?»

Brackeen, quien dijo que los datos de Stanford sobre la orientación sexual eran «sorprendentemente correctos«, dijo que debe haber un mayor enfoque en la privacidad y las herramientas para prevenir el uso indebido del aprendizaje automático a medida que se amplía y avanza.

Regla especuló acerca de la inteligencia artificial que se utiliza para discriminar activamente contra las personas basadas en la interpretación que hace una máquina de sus rostros: «Todos debemos estar colectivamente interesados«.