Hace ocho años, el grupo de investigación de Ted Adelson del Laboratorio de Informática e Inteligencia Artificial del MIT (CSAIL) presentó una nueva tecnología de sensores, llamada GelSight, que utiliza el contacto físico (una especie de sentido del tacto) con un objeto para proporcionar un mapa 3-D notablemente detallado de su superficie.

Ahora, mediante el montaje de sensores GelSight en las pinzas de los brazos robóticos, dos equipos del MIT han dado a los robots una mayor sensibilidad y destreza. Los investigadores presentaron su trabajo en dos ponencias en la Conferencia Internacional sobre Robótica y Automatización la semana pasada.

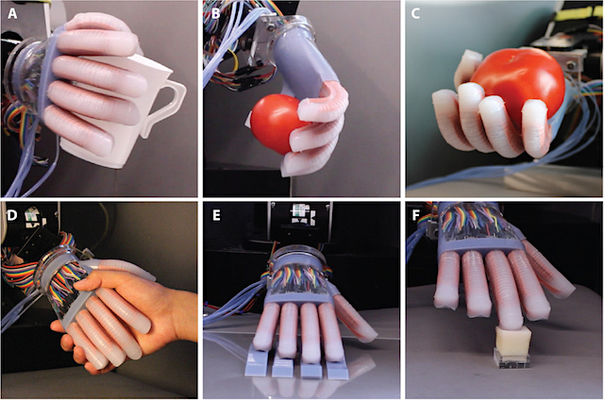

En un artículo, el grupo de Adelson utiliza los datos del sensor GelSight para permitir que un robot juzgue la dureza de las superficies que toca, una habilidad crucial si los robots domésticos manejan objetos cotidianos.

En el otro, el Rob Robot Locomotion Group de Russ Tedrake en CSAIL utiliza sensores GelSight para permitir a un robot manipular objetos más pequeños de lo que era posible anteriormente.

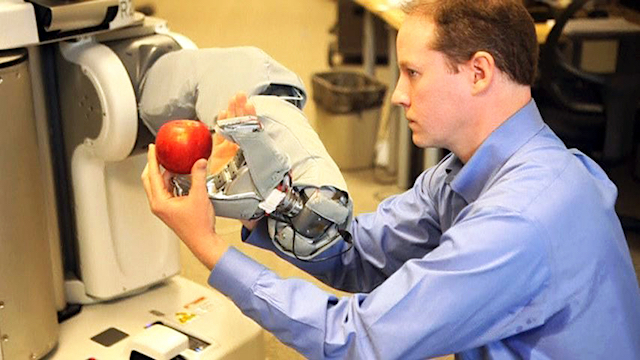

El sensor GelSight es, en algunos aspectos, una solución de no muy alta tecnología para un problema difícil. Consiste en un bloque de goma transparente una cara de la cual está recubierta con pintura metálica. Cuando la cara pintada se presiona contra un objeto, se ajusta a la forma del objeto.

La pintura metálica hace que la superficie del objeto sea reflexiva, por lo que su geometría se vuelve mucho más fácil para que los algoritmos de visión computarizada puedan inferir. Montado en el sensor opuesto a la cara pintada del bloque de goma hay tres luces de color y una sola cámara.

«El sistema tiene luces de colores en diferentes ángulos, y luego tiene este material reflectante, y al mirar los colores, la computadora … puede averiguar la forma tridimensional de lo que es esa cosa«, explica Adelson, el John Y Dorothy Wilson Profesor de Ciencias de la Visión en el Departamento de Ciencias Cerebrales y Cognitivas.

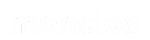

En ambos conjuntos de experimentos, se montó un sensor GelSight en un lado de una pinza robótica, un dispositivo algo parecido a la cabeza de una pinza, pero con superficies de agarre planas en lugar de puntas puntiagudas.

Puntos de contacto y sentido del tacto

Para un robot autónomo, medir la suavidad o la dureza de los objetos es esencial para decidir no solo dónde y cómo es de difícil de coger los objetos sino cómo se comportarán cuando se mueven, apilan o colocan sobre diferentes superficies. La detección táctil también podría ayudar a los robots a distinguir objetos que parezcan similares, sería como el sentido del tacto.

En trabajos anteriores, los robots han intentado evaluar la dureza de los objetos colocándolos sobre una superficie plana y suavemente empujándolos para ver cuánto resisten. Pero esta no es la forma principal en que los humanos miden la dureza. Más bien, nuestros juicios parecen estar basados en el grado en que el área de contacto entre el objeto y nuestros dedos cambia a medida que la presionamos. Los objetos más suaves tienden a aplanarse más, aumentando el área de contacto.

Los investigadores del MIT adoptaron el mismo enfoque. Wenzhen Yuan, un estudiante graduado en ingeniería mecánica y primer autor en el estudio del grupo de Adelson, usó moldes de confitería para crear 400 grupos de objetos de silicona, con 16 objetos por grupo. En cada grupo, los objetos tenían las mismas formas, pero diferentes grados de dureza, que Yuan midió usando una escala industrial estándar.

Entonces presionó un sensor de GelSight contra cada objeto manualmente y registró cómo el patrón del contacto cambió con el tiempo, esencialmente produciendo una película corta para cada objeto. Para normalizar el formato de datos y mantener el tamaño de los datos manejables, extrajo cinco fotogramas de cada película, espaciados uniformemente en el tiempo, lo que describió la deformación del objeto que se presionó.

Finalmente, alimentó los datos a una red neuronal, que buscó automáticamente correlaciones entre los cambios en los patrones de contacto y las mediciones de dureza. El sistema resultante toma marcos de vídeo como entradas y produce puntuaciones de dureza con una precisión muy alta. Yuan también llevó a cabo una serie de experimentos informales en los que los sujetos humanos palparon las frutas y verduras y los clasificó de acuerdo a la dureza. En todos los casos, el robot equipado con GelSight llegó a la misma clasificación; han sido los primeros pasos hacia el sentido del tacto cibernético.

Vistas obstruidas

El trabajo del Robot Locomotion Group nació de la experiencia del grupo con el Robotics Challenge (DRC) de la Defense Advanced Research Projects Agency, en el que equipos académicos e industriales compitieron para desarrollar sistemas de control que guiaran a un robot humanoide a través de una serie de tareas relacionadas con una emergencia hipotética.

Normalmente, un robot autónomo utilizará algún tipo de sistema de visión por ordenador para guiar su manipulación de los objetos en su entorno. Tales sistemas pueden proporcionar información muy fiable sobre la ubicación de un objeto, hasta que el robot recoge el objeto. Especialmente si el objeto es pequeño, gran parte de él será atrapado por la pinza del robot, haciendo la estimación sobre su ubicación mucho más difícil. Por lo tanto, exactamente en el punto en el que el robot necesita conocer la ubicación del objeto con precisión, su estimación se vuelve poco fiable. Este fue el problema que enfrentó el equipo del MIT durante la RDC, cuando su robot tuvo que recoger y encender un taladro eléctrico.

Es por eso que el Robot Locomotion Group se volvió a GelSight. Izatt y sus coautores – Tedrake, el Profesor de Toyota de Ingeniería Eléctrica y Ciencias de la Computación, Aeronáutica y Astronáutica, e Ingeniería Mecánica; Adelson; Y Geronimo Mirano, otro estudiante de postgrado en el grupo de Tedrake, diseñado algoritmos de control que utilizan un sistema de visión por ordenador para guiar la pinza del robot hacia una herramienta y luego convertir la estimación de ubicación a un sensor GelSight una vez que el robot tiene la herramienta en la mano.

En general, el desafío con este enfoque es conciliar los datos producidos por un sistema de visión con los datos producidos por un sensor táctil, que imitaría el sentido del tacto humano. Pero GelSight se basa en la cámara, por lo que su salida de datos es mucho más fácil de integrar con datos visuales que los datos de otros sensores táctiles.

En los experimentos de Izatt, un robot con una pinza equipada con GelSight tuvo que agarrar un destornillador pequeño, sacarlo de una funda y devolverlo a la posición inicial en el interior de su funda. Por supuesto, los datos del sensor de GelSight no describen el destornillador entero, apenas una pequeña parte de él. Pero Izatt descubrió que, mientras la estimación del sistema de visión de la posición inicial del destornillador fuera exacta en unos pocos centímetros, sus algoritmos podían deducir qué parte del destornillador tocaba el sensor GelSight y así determinar la posición del destornillador en la mano del robot.

«Creo que la tecnología GelSight, así como otros sensores táctiles de alto ancho de banda, tendrán un gran impacto en la robótica», dice Sergey Levine, profesor asistente de ingeniería eléctrica e informática de la Universidad de California en Berkeley. «Para los seres humanos, nuestro sentido del tacto es uno de los factores clave que facilitan nuestra asombrosa destreza manual. Los robots actuales carecen de este tipo de destreza y están limitados en su capacidad de reaccionar a las características de la superficie al manipular objetos. Si te imaginas buscando un interruptor de luz en la oscuridad, extrayendo un objeto de tu bolsillo, o cualquiera de las otras muchas cosas que puedes hacer sin siquiera pensar, dependiendo todos ellos del sentido del tacto.

«El software finalmente está alcanzando las capacidades de nuestros sensores», añade Levine. «Algoritmos de aprendizaje de máquinas inspirados en innovaciones en el aprendizaje profundo y la visión por computadora pueden procesar los ricos datos sensoriales de sensores como el GelSight, para deducir las propiedades del objeto. En el futuro, veremos este tipo de métodos de aprendizaje incorporados en habilidades de manipulación entrenadas de extremo a extremo, lo que hará que nuestros robots sean más hábiles y capaces, y tal vez nos ayuden a entender algo sobre nuestro propio sentido del tacto y el control motor «.